スクレイピングとは?定義や活用例、注意点をわかりやすく解説

インターネットの発達とともに、Web上には膨大な量のデータが存在するようになりました。そのデータを活用することで、ビジネスや研究に大きな価値を生み出すことができます。そこで注目されているのが、Web上のデータを自動的に収集する技術、「スクレイピング」です。

この記事では、スクレイピングとは何か、どのように活用されているのか、また注意点は何かについて、わかりやすく解説していきます。スクレイピングを正しく理解し、適切に活用することで、ビジネスや研究の可能性がさらに広がるでしょう。

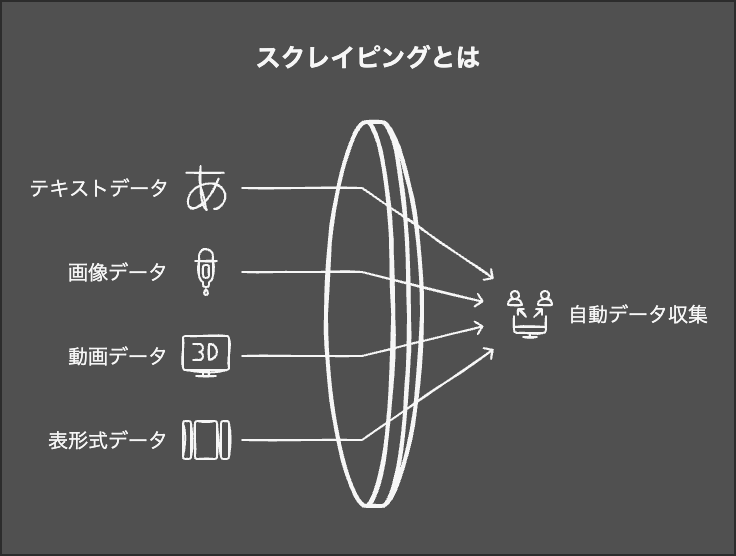

スクレイピングとはWeb上のデータを自動収集すること

スクレイピングとは、Web上に存在する大量のデータを、自動的に収集・抽出する技術のことを指します。英語で「scrape」は「こする、かき集める」という意味があり、そこから転じてコンピュータ用語として使われるようになりました。

Webサイトには、テキストデータだけでなく、画像や動画、表形式のデータなど、様々な種類のデータが存在します。スクレイピングを使えば、そうした多種多様なデータを、人の手を介さずに自動的に収集することが可能です。

収集したデータは、分析や機械学習のための材料として活用したり、別のサイトに転載したりと、様々な用途に役立てられます。ビジネスや研究の場面で、スクレイピングは欠かせない技術となっているのです。

データは様々な用途に使用できる

スクレイピングで収集したデータは、実にさまざまな用途で活用することができます。

具体的な例をいくつか挙げると、

- 競合他社の価格情報を収集し、自社の価格戦略に役立てる

- 消費者の口コミデータを分析し、商品開発や改善に生かす

- 不動産物件情報を集め、市場動向の調査や営業リストの作成に活用する

- ニュース記事を定期的にチェックし、自社に関する情報を素早くキャッチする

などが考えられます。このように、ビジネスのあらゆる場面で、スクレイピングが力を発揮するのです。

また研究分野でも、大規模なデータを使った分析や機械学習に、スクレイピングは欠かせません。例えば自然言語処理の研究では、Web上のテキストデータを大量に集めることが重要なステップとなります。

以下の記事では事例をまとめています。是非参考にしてみてください。

違法ではないが十分に注意する

スクレイピングは合法的な技術ですが、使い方によっては問題を引き起こす可能性もあるため、十分に注意が必要です。特に気をつけなければいけない点が2つあります。

- サーバーに過剰な負荷をかけない

- 著作権のあるデータを取得したときの活用には気をつける

まず、Webサーバーに過剰な負荷をかけ続けることは、サーバー運営者にとっては迷惑行為であり、場合によっては「業務妨害」とみなされる可能性があります。スクレイピングのプログラムを作る際は、適度な間隔でリクエストを送るなど、サーバー負荷を考慮した設計が求められます。

また、著作権の問題にも注意が必要です。著作物であるデータをスクレイピングした場合、転載や再利用には制限があります。データの利用規約をよく確認して、適切な範囲での活用にとどめるべきでしょう。著作権を侵害すれば、法的な責任を問われることになります。

スクレイピングに関連した用語

スクレイピングを理解するうえで、関連するいくつかの用語についても知っておく必要があります。ここでは、代表的なキーワードを取り上げ、その意味を簡潔に説明します。

- スクレーパー:スクレイピングを行うためのプログラムやツールのこと。Webページからデータを抽出する役割を担う。

- クローリング:Webサイトを自動的に巡回し、リンク先のページを次々にたどっていく処理のこと。サイトの構造を把握するために行われる。

- API:Application Programming Interfaceの略。Webサービスが外部のプログラムに対して提供する接続インターフェースのこと。定められた方法でデータをやりとりできる。

- ボット:Webサイトを自動的に巡回し、何らかの処理を行うプログラムの総称。スクレーパーやクローラーもボットの一種と言える。

- パース:Webページのソースコード(HTML)から、必要なデータを取り出す処理のこと。スクレイピングの中核をなす技術。

- セレクター:HTMLの構造の中から、特定の要素を指定するための記法。CSSセレクターやXPathなどがよく使われる。

これらの用語は、スクレイピングを実践する際に頻繁に登場します。それぞれの意味と関係性を理解しておくことで、スクレイピングの仕組みがより深く理解できるでしょう。

また、スクレイピングを行う際には、プログラミング言語やライブラリの知識も必要になります。よく使われるのは、Python、Ruby、JavaScriptなどの言語と、それぞれの言語で利用できるスクレイピング用のライブラリです。

代表的なライブラリとしては、Pythonならばscrapy、BeautifulSoup、Selenium、Rubyならばnokogiri、Puppeteer、JavaScriptならばjQuery、Cheerioなどが挙げられます。これらのツールを使いこなせば、スクレイピングの実装がぐっと効率的になるはずです。

スクレイピングの活用例

スクレイピングは、様々な業界や場面で活用されています。ここでは、代表的な活用例をいくつか紹介します。

営業リストの作成

新規開拓の営業活動において、見込み客のリストを作成することは重要な作業です。スクレイピングを使えば、Webサイトから企業名や連絡先などの情報を自動的に収集し、営業リストを効率的に作ることができます。

例えば、業界別のディレクトリサイトやニュースサイトから、ターゲットとなる企業の情報を抽出します。社名、住所、電話番号、メールアドレスなどのデータを自動的に収集し、表形式で整理することで、営業リストのベースが完成します。

これを手作業で行うとなると、膨大な時間と労力が必要になりますが、スクレイピングを活用すれば短時間で大量のデータを収集できるため、営業活動の生産性を大幅に高めることが期待できます。

ECサイト運営の自動化

ECサイトを運営する際、競合他社の価格変動をリアルタイムで把握することは非常に重要です。スクレイピングを使えば、競合サイトの商品ページを定期的にチェックし、価格情報を自動的に収集することができます。

収集したデータを分析することで、自社の価格設定や販売戦略の最適化に役立てられます。また、品切れ商品の検知や、新商品の発売情報の取得など、ECサイト運営に関わる様々なタスクを自動化することも可能です。

スクレイピングを活用することで、人手では対応しきれない大量のデータを効率的に処理でき、ECサイトの競争力を高めることにつながるでしょう。

レビュー・口コミの収集

商品やサービスの改善にあたって、ユーザーのレビューや口コミは貴重な情報源となります。スクレイピングを使えば、ECサイトやレビューサイトに投稿された大量のレビューデータを自動的に収集することができます。

収集したレビューデータをテキストマイニングの手法で分析することで、ユーザーの生の声を製品開発やマーケティングに活かすことが可能です。例えば、よく言及されているキーワードを抽出したり、肯定的・否定的な評価を判別したりと、様々な角度からレビューを分析できます。

また、自社製品に関するレビューを定期的にチェックすることで、不具合の早期発見や、ユーザーニーズの把握にも役立ちます。スクレイピングを活用したレビュー収集は、ユーザー視点でのサービス改善に大きく貢献するでしょう。

以上、スクレイピングの代表的な活用例を見てきました。ビジネスの様々な場面で、スクレイピングが活躍の場を広げています。データに基づく意思決定が求められる昨今、スクレイピングは欠かせない技術となっているのです。

もちろん、これらはほんの一例に過ぎません。スクレイピングの可能性は無限大です。ビジネスの課題に応じて、創意工夫を凝らしながら活用方法を考えていくことが大切だと言えるでしょう。

スクレイピングを導入すべきケース

スクレイピングは、様々なシーンで威力を発揮する技術ですが、特に以下のようなケースでは導入を検討すべきでしょう。

大量のデータ収集を自動化したい

Webサイトから情報を手作業で収集していては、膨大な時間と労力がかかってしまいます。スクレイピングを導入することで、大量のデータを自動的に収集できるようになります。

例えば、店舗情報や不動産物件情報、求人情報など、定型的なデータを大量に収集する必要がある場合、スクレイピングが非常に有効です。人手での作業を自動化することで、業務の効率化と高速化が実現できるでしょう。

市場・競合調査を自動化したい

自社の事業戦略を立てる上で、市場動向や競合他社の情報を把握することは欠かせません。スクレイピングを使えば、関連するデータを自動的に収集し、分析に活用することができます。

例えば、競合他社の価格情報や新商品情報、キャンペーン情報などをリアルタイムで取得することで、素早く市場の変化に対応することが可能です。また、収集したデータを分析・加工して、レポートを自動生成することもできるでしょう。

さらに、テキストマイニングの一種であるセンチメント分析を行えば、ユーザーの評判や反応を自動的に検知することもできます。例えば、SNS上の自社製品に関する投稿を収集し、ネガティブな内容があれば自動でアラートを上げるなど、リスク管理にも役立てられます。

比較サイト・ニュースサイトの作成

スクレイピングは、Webメディアの運営にも活用できます。比較サイトやニュースサイトを作る際、他サイトから情報を自動的に収集・更新することで、コンテンツ制作の手間を大幅に削減できます。

例えば、家電製品の価格比較サイトを運営する場合、各ECサイトから製品情報や価格データを定期的に収集することで、常に最新の情報を提供し続けることが可能です。

また、ニュースサイトの場合、複数のメディアから関連記事を自動的に収集し、要約を作成するなど、効率的なコンテンツ制作が実現できます。単純な情報の転載ではなく、付加価値を加えることが重要ですが、スクレイピングを活用すれば、そのための時間と労力を捻出しやすくなるでしょう。

スクレイピングシステムの開発費用

スクレイピングシステムの開発費用は、規模や目的、必要な機能によって大きく変動します。

最小限の機能で済ませる場合は20万円程度から開発可能ですが、高度な機能を備えた本格的なシステムになると200万円以上かかることもあります。

| 規模 | 費用 |

|---|---|

| 最低限の規模 | 20万円〜50万円 |

| 社内だけで使える規模 | 50万円〜100万円 |

| 一般公開する規模(アプリとして公開する場合など) | 100万円〜200万円 |

スクレイピングの開発費用について、詳しくは以下の記事をご覧ください。

スクレイピングOKか調べる方法

スクレイピングを行う前に、対象となるWebサイトがスクレイピングを許可しているかどうかを確認することが重要です。以下の方法で、スクレイピングの可否を判断しましょう。

- 利用規約を確認する

- サイトの利用規約をチェックし、スクレイピングについての記載を探します。

- 「データ収集」「クローリング」「ボット」といったキーワードで検索すると見つけやすいでしょう。

- APIの有無を確認する

- サイトがデータ提供用のAPIを用意している場合、基本的にはそちらの利用が推奨されています。

- APIがあるということは、「APIを使ってデータを取得し、スクレイピングはしないでください」というメッセージと受け取れます。

- robots.txtを確認する

- Webサイトのルートディレクトリにあるrobots.txtファイルを確認します。

- クローラーによるアクセスを拒否するDisallowディレクティブが設定されている場合、そのサイトではスクレイピングが好まれていないと判断できます。

- 実際に試してみる

- 実際にスクレイピングを試みると、禁止しているサイトでは警告が表示されることがあります。

- ブラウザのヘッドレスモードを検知して警告を出すなどの対策が取られているようです。

以上の方法を組み合わせることで、スクレイピングが禁止されているかどうかを見極められます。判断に迷う場合は、念のため控えめにするのが無難でしょう。

Webサイトの中には、スクレイピングを明示的に禁止していないものの、過度なアクセスに対しては制限をかけているケースもあります。例えば、短時間に大量のリクエストを送りつけると、一時的にIPアドレスがブロックされるなどの措置が取られることがあります。

スクレイピングできないサイト例(APIで可能)

一部の大手サイトでは、スクレイピングが明示的に禁止されています。ただし、多くの場合、APIを通じてデータを取得することは可能です。以下に、代表的なサイトを挙げます。

X(Twitter)

Xでは、利用規約でスクレイピングが禁止されています。ただし、公式のAPIを使えば、ツイートやユーザー情報などのデータを取得できます。APIを利用する際は、認証が必要となり、利用可能な機能や取得できるデータ量に制限があります。

Instagramもスクレイピングを禁止しており、利用規約で明示されています。代わりに、Graph APIを利用することで、ユーザーの投稿や関連データを取得することができます。ただし、APIの利用にはFacebookデベロッパーアカウントが必要です。

Facebookもスクレイピングを禁止しています。代わりに、Graph APIを利用することで、ユーザーの投稿やページのデータを取得できます。APIの利用には、Facebookデベロッパーアカウントと認証が必要です。

YouTube

YouTubeでは、利用規約でスクレイピングが禁止されています。ただし、YouTube Data APIを使えば、動画の情報や統計データ、コメントなどを取得できます。APIの利用には、Google Developers Consoleでのプロジェクト作成と認証が必要です。

Amazon

Amazonの利用規約では、スクレイピングが明示的に禁止されています。代わりに、Product Advertising APIを利用することで、商品情報やレビューデータを取得できます。APIの利用には、Amazon Associatesプログラムへの登録と認証が必要です。

楽天

楽天もスクレイピングを禁止しており、利用規約で明示されています。代わりに、楽天ウェブサービスを利用することで、商品情報や価格データを取得できます。APIの利用には、楽天デベロッパーズプログラムへの登録と認証が必要です。

eBay

eBayの利用規約では、スクレイピングが明示的に禁止されています。代わりに、eBay Developer Programを通じて提供されるAPIを利用することで、商品情報や取引データを取得できます。APIの利用には、eBayデベロッパープログラムへの登録と認証が必要です。

スクレイピングの進め方

スクレイピングを実践する際は、適切な手順を踏むことが重要です。ここでは、スクレイピングプロジェクトを進める上での基本的な流れを説明します。

1. 解決したい課題と必要なデータを洗い出す

まず初めに、スクレイピングで解決したい課題を明確にしましょう。課題を具体的に定義することで、必要なデータの種類や範囲が見えてきます。

例えば、競合他社の価格動向を把握したいのであれば、競合サイトの商品名や価格、在庫状況などのデータが必要になります。一方、顧客の声を収集したい場合は、SNSの投稿内容や評価サイトのレビューデータが対象となるでしょう。

課題と必要データを紐付けて整理することで、スクレイピングの目的が明確になり、効率的なデータ収集が可能になります。

2. 取得方法を考える

次に、必要なデータをどのように取得するかを検討します。対象となるWebサイトがAPIを提供している場合は、APIを利用するのが得策です。APIを使えば、サイトの規約に沿った形でデータを取得できます。

一方、APIが提供されていない場合は、Webスクレイピングを検討します。その際は、サイトの利用規約を確認し、スクレイピングが許可されているかどうかを必ず確認しましょう。

また、取得するデータの量や頻度、形式なども考慮する必要があります。大量のデータを高頻度で取得する場合は、サーバーへの負荷に配慮が必要です。データの形式は、JSON、CSV、XMLなど、用途に応じて適切なものを選択しましょう。

3. スクレイピングシステムを開発する

データ取得方法が決まったら、実際にスクレイピングシステムを開発します。一般的には、Python、Ruby、JavaScriptなどのプログラミング言語を使って、スクレイピング用のスクリプトを記述します。

開発する際は、以下の点に留意しましょう。

- 対象のWebサイトに過度な負荷をかけないよう、アクセス頻度を制御する

- 取得したデータを効率的に処理・保存できるよう、データパイプラインを設計する

- エラーハンドリングを適切に行い、システムの堅牢性を確保する

- 将来の変更に備えて、メンテナンス性の高いコードを心がける

スクレイピングシステムの開発は、一定の技術力を要します。専門的な知識が必要な場合は、エンジニアと協力して進めることをおすすめします。

4. 活用しつつ改善していく

スクレイピングシステムが完成したら、実際に運用を開始します。取得したデータを分析に活用し、ビジネス課題の解決に役立てましょう。

運用と並行して、システムの改善も継続的に行います。データ取得の精度や効率を高めるため、定期的にコードをレビューし、必要な修正を加えていきます。また、対象サイトの構造変更などにも柔軟に対応できるよう、メンテナンス性を維持することが大切です。

さらに、スクレイピングで得られた知見を元に、新たな課題を発見し、システムの拡張を検討することも重要です。ビジネスの変化に合わせて、スクレイピングの対象や手法を柔軟に見直していくことが、継続的な価値創出につながるでしょう。

スクレイピングならニューラルオプト

スクレイピングを検討する際は、専門知識と豊富な実績を持つ開発会社に相談することをおすすめします。

DX(デジタルトランスフォーメーション)の実現と、質の高いシステム開発を手掛ける合同会社ニューラルオプトは、スクレイピング技術に精通した集団です。

データ活用の重要性が高まる中、スクレイピングの導入を検討してみてはいかがでしょうか。合同会社ニューラルオプトは、お客様のビジネス成長に貢献するため、全力でサポートいたします。